社会とつながる脳 ― BMIと脳デコーディングがもたらす医療革新と未来社会

近年の医療用機器の発展はめざましいものがありますが、特にBMI(ブレイン・マシン・インターフェイス)と呼ばれる技術は、脳と機器を繋ぐことで、人間の脳活動を外に取り出し、様々な「身体の壁」例えば運動・感覚障害を乗り越えることを可能にしつつあります。さらに近年では、運動にとどまらない、人間の心的イメージや思考、果ては「夢」といった抽象的な脳内世界が、「脳デコーディング」と呼ばれる驚くべきBMI技術により人間の外の世界と直接つながろうとしています。

脳と機械を繋ぐ BMI(ブレイン・マシン・インターフェイス)

人間の脳内の神経活動で表象されているものが、脳から出て外の世界で一定の意味を持つためには、その内容を周りにわかる形(言葉、ジェスチャー、表情、絵など)に変換しなければなりません。その際にはどうしても何らかの運動システムを使わなければならず、最後の関門は「身体」ということになります。身体のチャネルを使わずに、人間の自発的な意思に基づく「運動(身体活動)」を実行できれば、身体の障害を持っている人の機能不全を補完できる可能性があります。

BMI(ブレイン・マシン・インターフェイス)とは、脳と機械の間で(直接に)信号をやり取りして、神経機能を代替・回復・改善する技術です1,2。BMIは主に、脳に電極を埋め込むような侵襲的手法を指すことが多く、頭皮から脳波を測定して取り出すような非侵襲的手法はBCI (ブレイン・コンピュータ・インターフェイス)と呼ばれることもあります。古典的なBMIでは、中枢神経や末梢神経に埋植した針型電極を介して計測した神経細胞の発火頻度をリアルタイムで解析し、その結果に基づいて外部機器装置を動かす様なアプローチが取られます。

BMI研究の歴史は、その最古のものとして1960年代に脳波による外部装置制御を行う研究がなされ、その後も細々と研究は行われ次第にBCIの概念は創られていったのですが、実際インパクトを与えた最初の研究は、誘発脳波の一種である事象関連電位P300を使用した研究に遡ります3。それはモニター上に並べられた文字の中から入力したいある一つの文字に注意を向けさせた上で、並べられた文字を順番に点灯し、その意図する文字が点灯した刺激によりほぼ300msec後に誘発される陽性波であるP300 反応を検出して文字入力が可能であることを示した研究でした。これは、重度の運動障害を持つために意思疎通不可能であったALS患者などの意思伝達を行うことを目指した画期的なものでしたが、視覚刺激提示、すなわち視力の仲介が必須であり、速度が遅いという欠点もありました。脳から直接脳活動を取り出すことによるBMI研究の始まりは、4半世紀も前にNature Neuroscience誌に発表されたラットのレバー押し実験でした4。まずラットに、前足でレバーを押すと水飲み用のアームが動いて水が飲める実験装置を用いて、レバー押し行動を学習させます。次に、レバーを押してもアームは動かないが、レバーを押す際に生じるラット運動野の神経細胞集団の活動だけでもアームが動くようにしてレバー押し行動をしばらくさせると、ラットはレバー押し行動を行わずに運動野の神経細胞集団を活動させただけでアームを動かして水を飲むようになったのです。この研究の後、2000年代に入り、同様の実験がサルやヒトでも実施されるようになり、四肢が麻痺した患者が、自身の脳に設置された電極を介して計測される神経活動を変化させ、コンピュータのソフトウェアやロボット義手の操作ができるような医療応用が試みられるようになりました。現在のところ、脳と手指をつなぐ神経代償回路をBMIで活性化するような医療機器が、日本でも承認されています5。

近年のBMIの精度の進化は目を見張るものがあります。18年前の脳卒中で発話不能になった患者に高密度脳表電極を埋込み、患者の脳活動から自然な速度での発話・顔の表情・非言語的なジェスチャーまで復元したとする研究6、脊髄損傷から10年経過した患者に、脳と脊髄を直接つなぐ「デジタルブリッジ」を構築し、階段・坂道・障害物を含む地形での自然な歩行を回復させた研究7、脊髄損傷による四肢麻痺患者の運動野に電極を埋込み、ビデオゲームのコントロールを可能にさせた研究8、発話障害を来している神経疾患患者の脳活動からリアルタイムで自然な音声を生成し、リアルタイムコミュニケーションを実現させた研究9など、驚くべき報告が相次いでいます。

このように、脳の中から、運動の指令を取りだし、運動障害の患者さんをサポートするBMI技術による挑戦は、すでに製品になったものや治験段階に入ったものを含めて、もう臨床への応用段階に入っていると言っても過言ではありません。

脳の中に生まれた「イメージ」を取り出す ― 脳デコーディング

私たちが目にしている世界、頭の中で思い描くイメージは脳の神経活動の産物です。従来の脳機能画像技術では、何か物を見ていると大まかに視覚野が活動することはわかっていましたが、視覚野の活動から何を見ているのかの詳細を逆推定する事は不可能と思われていました。しかし、その脳活動から「何を見ているのか」「何を想像しているのか」― つまりその人のまさに脳内の世界 ― を逆推定して画像として再構築する「脳デコーディング」と呼ばれるBMI技術が、近年驚くような発展を遂げています10。

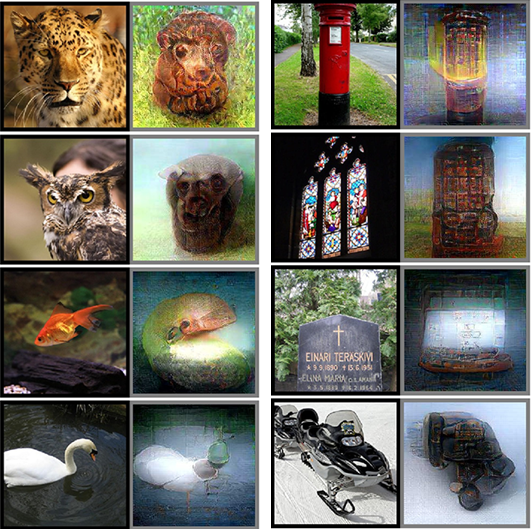

この分野における初期の重要な一歩は、2005年にNature Neuroscience誌に発表された京都大学の神谷之康教授とTong博士の研究11で、fMRIの微細な脳活動シグナルを多数の画素が作り出す「パターン」として解析し、人が視覚的に見ている縞模様の方向をわずかな脳シグナルから高精度で予測する技術を開発しました。この功績により、神谷教授はScientific American誌が選んだ2005年の「科学技術に貢献した50人」に選ばれました。その後この技術は発展し、2008年には被験者が見た画像を10×10ピクセルの白黒画像に再構築することに成功し12、現在ではAI技術と組み合わせ、物体を見たヒトの脳活動から任意の自然界の物体イメージや、さらにコンピュータの訓練データにはない人工的な形状まで高い精度で再構築できるようになりました13,14(下図参照)。まさに、ヒトの脳をAIと繋げて、頭の中の視覚的イメージを取り出すことに成功したわけです。

図:被験者が見た写真(1・3列目)と、被験者のfMRI脳活動シグナルのみから再構築した画像(2・4列目)。Shenら14より引用(CC BY 4.0)

さらに脳デコーディングは、単なる視覚的な入力の再現ではなく、心の中で「想像で」イメージした物体 (たとえば「象」や「飛行機」)15 、注意を向けた画像16、果ては視覚的錯覚 (たとえば静止画なのに動いて見える錯視) により心の中でできあがったイメージ17、といった「主体的な体験そのもの」を視覚的に再構築する事を可能にしつつあります。特に注目を集めたのが、「夢」の内容の予測という、2013年にScience誌に発表された研究です18。夢は究極的に主観的な体験であり、客観的な分析は不可能とされてきましたが、研究チームは、夢も脳の視覚野において表現されると考え19、覚醒時に視覚刺激を見ているときの脳活動データによる予測アルゴリズムを睡眠中に夢を見ているときの脳活動に応用し、結果として、平均で60~70%の精度で夢の内容を予測する事に成功したのです18。

医療応用への期待

この脳デコーディング技術は、神経科学の基礎研究だけでなく、臨床医療への応用も期待されています10。統合失調症やパーキンソン病、レビー小体型認知症などで生じる幻視は、患者本人の主観的体験であり、客観的な評価が困難でした。脳デコーディング技術を用いれば、幻覚として「何が見えているのか」を画像として再構築し、診断や治療効果の評価、さらには治療方針の決定に役立てられる可能性があります。また、視覚的イメージの再構築技術を統合すれば、重度の運動障害を持つ患者が、視覚的なイメージそのものをコミュニケーション手段として利用できるようになります。言葉で表現できない患者が、頭の中で思い描いた風景や人物を画像として外部に伝えることが可能になるでしょう。さらに、脳デコーディングは内的な心理状態を詳細な画像として外在化できることから、精神疾患の診断や認知機能の評価に、より精密で包括的なアプローチを導入できる可能性も生まれます。

「脳が脳と繋がる」ー 脳脳間インターフェース

また、今新たに勃興している脳科学研究領域として、脳情報を、他の人の脳と繋げる「脳脳間インターフェース」(Brain-to-Brain Interface: BBI) と呼ばれる技術があります。2015年に発表された「複数の脳で有機コンピューティングデバイスをつくる」という目を見張るタイトルの論文20では、4匹のラットの脳に埋め込んだ電極から神経活動をお互いのラットに皮質への電気刺激で相互送信することで分散並列計算を行う「ブレインネット」を構築しました。いわば複数の「脳をCPUに例えたもの」といったところですが、このブレインネットはなんと天気予報を含むいくつかの計算タスクを処理します20。また、ヒトにおけるBBI研究も行われつつあり、ある人の脳からの信号を脳波で取得し、その信号を他の人の脳へ経頭蓋磁気刺激 (TMS) で入力することで脳脳通信をする「ヒューマン・ブレインネット」を構築し、複数の脳が協調して「20の質問ゲーム」(送信者がある物体を思い浮かべ、受信者がイエスかノーかの質問のみでそれを当てる) やテトリスゲームをすることすら可能になっています21,22。

近未来的な展望

人間の心の中の情報を、脳デコーディングのようなBMI/BCIで取り出し、その情報が脳脳間インターフェイスで直接繋がれば、言語や身体といったコミュニケーションでのボトルネックを越え、多くの人間のイメージや思考がシームレスに協調することができる、まさに人間拡張の世界になることが想像されます。イギリスの経済誌The Economistは、2013年の記事の中で、BCIの進化により2040年までには人々は脳に埋め込まれたチップを通じてサーバーと繋がり、互いにテレパシー的に通信しているかもしれない、と予測しています23。もちろん何らの科学的な根拠はない予測ですが、これまで見てきた脳情報抽出の技術革新からは、あながち荒唐無稽な主張ではないのかも知れません。

こうした技術革新は、神経科学と人工知能が融合した、まさに新しい医療・科学のフロンティアです。そして、私たちの脳と意識の理解を根本から変え、医療の可能性を飛躍的に広げるでしょう。